Data publikacji: 30-04-2025 | Data aktualizacji: 30-04-2025 | Autor: Piotr Kurpiewski

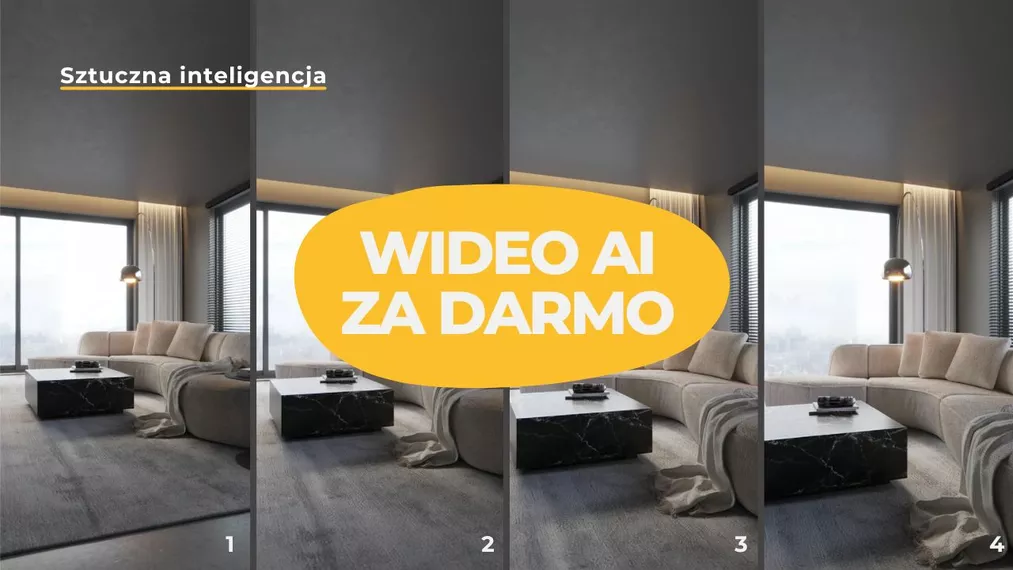

Generowanie wideo AI za darmo - szybkie animacje 3D dzięki WAN 2.1

WAN 2.1 to darmowy model AI od Alibaby umożliwiający szybkie generowanie animacji 3D z tekstu lub obrazów. Dzięki niemu możesz łatwo ożywić wizualizacje wnętrz i architektury, tworząc profesjonalne materiały marketingowe i prezentacje projektowe. Model działa lokalnie, oferuje kontrolę nad ruchem kamery i jest dostępny bezpłatnie nawet do użytku komercyjnego. W artykule dowiesz się, jak z niego korzystać, jakie są dostępne modele i jak w prosty sposób wzbogacić swoje projekty o dynamiczne wideo.

Szukasz sposobu na szybkie tworzenie animacji z wizualizacji 3D? Dzięki darmowemu modelowi WAN 2.1 możesz generować filmy z obrazów lub tekstu na własnym komputerze - błyskawicznie, bez kosztów licencyjnych i bez konieczności posiadania rozbudowanego studia graficznego.

Co to jest model WAN 2.1? Darmowe narzędzie AI do animacji 3D

WAN 2.1 to nowoczesny model sztucznej inteligencji opublikowany przez Alibaba Group na licencji Apache 2.0. Oznacza to, że możesz go używać zupełnie za darmo, także do zastosowań komercyjnych. Model umożliwia generowanie krótkich sekwencji wideo na trzy różne sposoby: na podstawie tekstu, jednego obrazu lub dwóch obrazów (startowego i końcowego).

Warto szczególnie podkreślić, że w przeciwieństwie do wielu innych generatorów AI, WAN oferuje bardzo wysoką kontrolę nad rezultatem. Dzięki wykorzystaniu pierwszej klatki lub kombinacji pierwszej i ostatniej klatki, możliwe jest tworzenie animacji praktycznie nieodróżnialnych od klasycznie renderowanych sekwencji w programach 3D, takich jak Blender, 3ds Max czy SketchUp.

Sposoby generowania wideo AI w WAN 2.1: tekst, obraz, dwa obrazy

Generowanie wideo AI z tekstu (promptu)

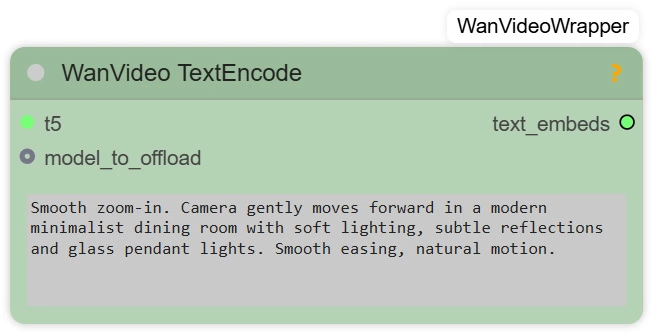

WAN 2.1 umożliwia tworzenie wideo na podstawie promptu tekstowego, w którym określasz wygląd sceny, styl animacji, ruch kamery i akcję w kadrze. Ważne, aby prompt był napisany po angielsku lub chińsku! Chiński działa lepiej, ale nie martw się, większość z nas nie zamierza nagle uczyć się mandaryńskiego. Rezultaty, które widzisz w tym artykule stworzyłem wykorzystując prosty język angielski.

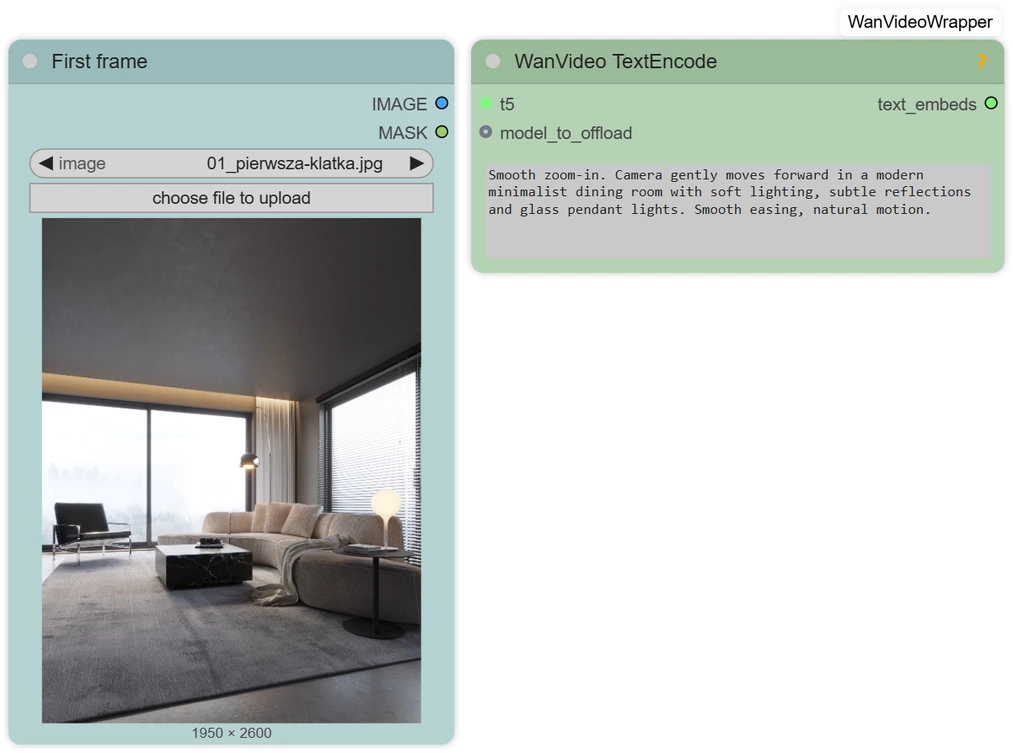

Tworzenie animacji AI z obrazu w modelu WAN 2.1

W tej opcji dodajesz pojedynczy obraz jako klatkę początkową filmu. Model interpretuje obraz oraz prompt. Kluczowym parametrem jest CFG (Classifier-Free Guidance):

- Wyższe CFG oznacza, że model mocniej sugeruje się tekstem promptu,

- Niższe CFG sprawi, że model będzie wierniej trzymał się obrazu.

To rozwiązanie jest świetne do animowania statycznych wizualizacji architektonicznych, dodając subtelny ruch kamery lub drobne zmiany atmosfery.

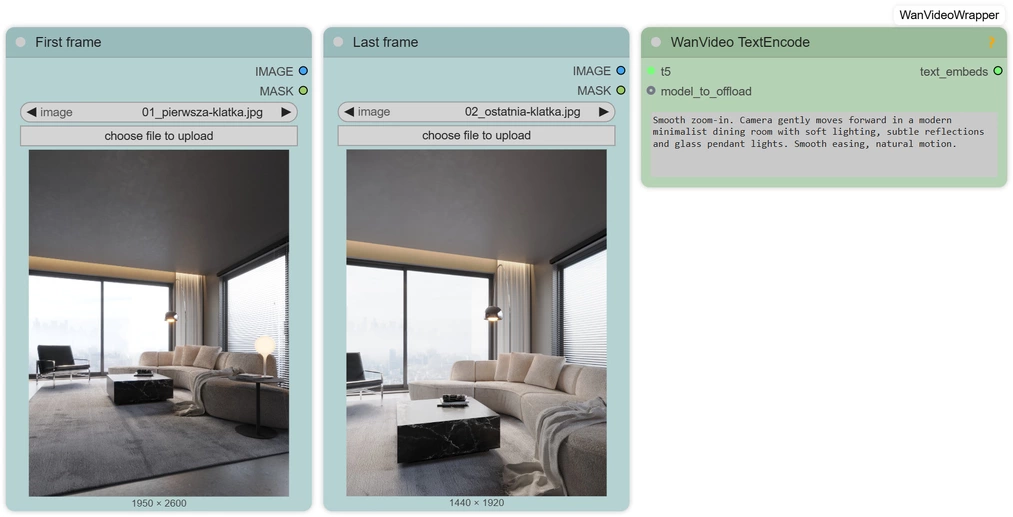

Tworzenie animacji 3D na podstawie dwóch obrazów (first frame i last frame)

Najbardziej zaawansowana opcja. Podajesz pierwszy i ostatni obraz, a AI tworzy płynne przejście między nimi. To podejście jest niezwykle podobne do klasycznego sposobu animowania sceny w programach takich jak Blender czy 3ds Max, gdzie definiujemy kluczowe klatki (tzw. keyframes). W przypadku WAN 2.1 dodatkową przewagą jest szybkość i brak konieczności ręcznego ustawiania każdego kroku pośredniego.

Modele WAN 2.1 - rozdzielczości, parametry i wymagania sprzętowe

WAN 2.1 oferuje modele trenowane na rozdzielczościach 480p i 720p. Na modelach 720p można generować nawet wideo 1080p, choć jakość detali może nieco odbiegać od natywnego 1080p ze względu na dane treningowe.

Istnieją:

- Lżejsze modele, które mają mniej parametrów, ale umożliwiają szybsze generowanie na słabszym sprzęcie.

- Pełne modele z większą liczbą parametrów, które gwarantują wyższą jakość animacji, ale też większe wymagania sprzętowe (największy model to około 30 GB!).

- Modele quantized, czyli skompresowane przez społeczność AI wersje modeli, które działają na kartach graficznych z mniejszą ilością VRAM.

Na start polecamy lekki model 480p, a dla pełnej kontroli model 720p z obsługą dwóch klatek.

Opcjonalnie można przyspieszyć generowanie wykorzystując algorytm TeaCache, który poprawia czas tworzenia animacji, przewidując kolejne obliczenia, ale nie jest wymagany na początku.

Jak korzystać z WAN 2.1 - lokalnie i online?

Jak uruchomić WAN 2.1 lokalnie na własnym komputerze?

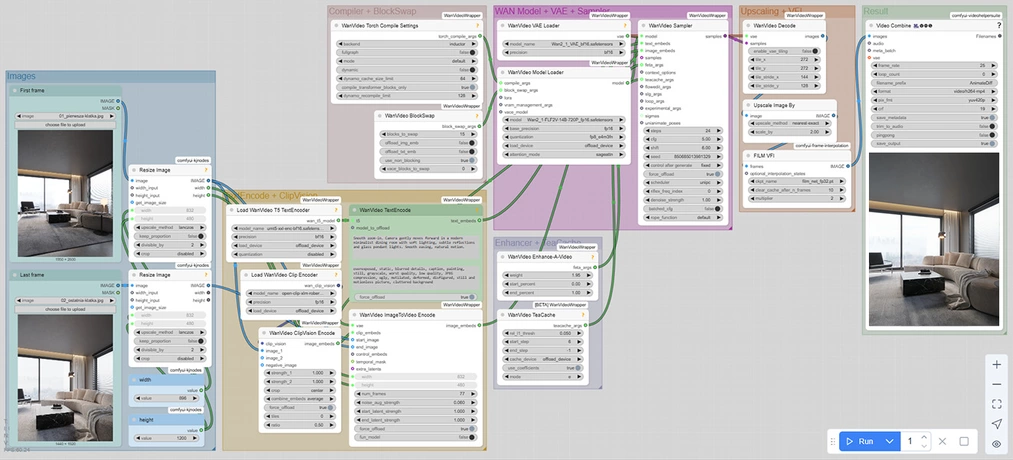

Najwygodniejszy sposób to wykorzystanie ComfyUI wraz z zestawem node'ów ComfyUI-WanVideoWrapper stworzonym przez kijai. Aby korzystać z tego rozwiązania lokalnie, będziesz potrzebować:

- ComfyUI z podstawową konfiguracją,

- Node'ów WAN do ComfyUI,

- Modeli WAN 2.1

- karty graficznej z przynajmniej 8 GB VRAM (rekomendowane więcej),

- umiejętności podstawowej obsługi środowiska Python i instalacji bibliotek.

Obecnie wymaga to pewnej wiedzy technicznej. Poniżej zamieszczam zrzut ekranu kompletnego workflow z ComfyUI. Rozwój narzędzi AI postępuje szybko i można się spodziewać, że już wkrótce pojawią się łatwiejsze w obsłudze rozwiązania.

Jak korzystać z WAN 2.1 online za darmo?

Dla osób, które nie chcą instalować niczego lokalnie, dostępny jest generator online na stronie wan.video. W darmowym planie obowiązują ograniczenia czasowe i ilościowe, ale można łatwo przetestować możliwości WAN 2.1.

Da się nawet tworzyć animacje na podstawie klatki początkowej i końcowej, a jakość wygenerowanych w ten sposób sekwencji wcale nie odbiega tak bardzo od tego, co można zrobić lokalnie w ComfyUI.

Jak wykorzystać WAN 2.1 do animacji wizualizacji 3D i architektury?

Animacje wnętrz

WAN 2.1 świetnie sprawdza się w tworzeniu subtelnych animacji wnętrz, które w naturalny sposób ożywiają statyczne wizualizacje. Możesz dodać delikatny ruch kamery wokół mebli, symulować falowanie zasłon na wietrze czy wprowadzić płynne zmiany oświetlenia w ciągu dnia. Dzięki temu nawet prosta wizualizacja zyskuje głębię i atmosferę, która znacznie zwiększa jej atrakcyjność w oczach klienta.

Animacje architektury

W przypadku wizualizacji architektonicznych model pozwala na łatwe tworzenie efektownych przelotów kamery wokół budynków, tarasów czy ogrodów. Możesz symulować powolne najazdy kamery na elewację, obroty wokół bryły budynku lub dynamiczne ujęcia wprowadzające widza na dziedziniec czy do wnętrza obiektu. Takie animacje znakomicie prezentują całe inwestycje oraz podkreślają detale architektoniczne, które trudno wyeksponować na statycznych obrazach.

Materiały marketingowe

WAN 2.1 otwiera nowe możliwości w tworzeniu krótkich materiałów promocyjnych do social mediów, reklam internetowych czy portfolio. Kilkunastosekundowe animacje generowane na bazie istniejących wizualizacji mogą zwiększyć zainteresowanie projektem, podnieść profesjonalizm prezentacji i przyciągnąć uwagę potencjalnych klientów. Szczególnie dobrze sprawdzają się tutaj lekkie ruchy kamery, zmieniające się warunki oświetlenia lub płynne przejścia między pomieszczeniami.

Prezentacje koncepcji

Ten workflow doskonale sprawdza się również na wczesnych etapach projektowych. Możesz szybko przygotować animowane koncepcje przestrzeni - idealne na konkursy, przetargi czy spotkania z inwestorem. Nawet proste przejście z pierwszej do ostatniej klatki pozwala pokazać ideę projektu w znacznie bardziej angażujący sposób niż zwykła statyczna wizualizacja.

WAN 2.1: darmowe animacje AI dla architektów i projektantów 3D

WAN 2.1 to przełomowe narzędzie, które otwiera nowe możliwości dla architektów, projektantów wnętrz oraz twórców wizualizacji 3D. Dzięki licencji Apache 2.0 możesz korzystać z niego zupełnie za darmo, również do zastosowań komercyjnych. Co więcej, model działa lokalnie na Twoim komputerze, co oznacza pełne bezpieczeństwo danych projektowych i brak konieczności korzystania z usług chmurowych.

Największą przewagą tego modelu nad innymi rozwiązaniami jest jednak niezwykle wysoka kontrola nad procesem generowania animacji. Dzięki możliwości definiowania klatek początkowych i końcowych masz wpływ na całą sekwencję ruchu, podobnie jak w profesjonalnych programach do animacji 3D.

Obecnie konfiguracja lokalnego środowiska ComfyUI wymaga jeszcze podstawowej znajomości Pythona i umiejętności instalacji bibliotek, dlatego narzędzie to jest zarezerwowane raczej dla bardziej zaawansowanych użytkowników. Warto jednak obserwować jego rozwój, ponieważ wiele wskazuje na to, że w najbliższym czasie pojawią się jeszcze prostsze rozwiązania, które umożliwią generowanie animacji w WAN 2.1 bez konieczności głębszej wiedzy technicznej.

AI kontra tradycyjne tworzenie animacji w Blenderze i 3ds Max

Tworzenie animacji w klasycznym 3D (np. w Blenderze) daje pełną kontrolę nad każdym aspektem ruchu, ale wymaga dużej ilości czasu, wiedzy i mocy obliczeniowej. Wykorzystując do tego sztuczną inteligencję:

- nie musisz ręcznie ustawiać wszystkich kluczowych klatek (tzw. keyframes);

- proces renderingu jest wielokrotnie szybszy;

- możesz uzyskać płynne, estetyczne efekty bez znajomości zaawansowanych technik animacyjnych.

Oczywiście AI nie zastąpi pełnego warsztatu animatora 3D, ale w wielu projektach komercyjnych efekt będzie zupełnie wystarczający.

Podsumowanie: Czy warto zainteresować się animacjami AI?

Jeśli zajmujesz się projektowaniem wnętrz, architekturą lub tworzeniem wizualizacji 3D, WAN 2.1 jest narzędziem, które zdecydowanie warto poznać. Pozwala szybko wzbogacić Twoje projekty o dynamiczne animacje, zwiększyć atrakcyjność portfolio oraz tworzyć materiały marketingowe w sposób tani, szybki i elastyczny.

Jeśli chcesz lepiej poznać możliwości sztucznej inteligencji sprawdź nasz kurs Stable Diffusion w architekturze i projektowaniu wnętrz! To świetny start dla początkujących i doskonałe dopełnienie warsztatu specjalistów.

Przeczytaj o AI - Sztuczna inteligencja na naszym blogu

-

![GPT Image 1.5 vs Nano Banana Pro - porównanie generatorów grafik AI w 12 testach]()

GPT Image 1.5 vs Nano Banana Pro - porównanie generatorów grafik AI w 12 testach

GPT Image 1.5 vs Nano Banana Pro - 12 identycznych zadań, dwa generatory AI. Sprawdź, który wygrywa! -

![Ludzie w wizualizacjach: jak dodawać realistyczne postacie w Nano Banana Pro?]()

Ludzie w wizualizacjach: jak dodawać realistyczne postacie w Nano Banana Pro?

Twoje wizualizacje są puste? Naucz się dodawać realistycznych ludzi w Nano Banana Pro i tworzyć wideo z Google Veo. Sprawdź nasz poradnik! -

![SketchUp i Nano Banana Pro: fotorealistyczne wizualizacje w 5 minut! Czy to koniec V-Raya?]()

SketchUp i Nano Banana Pro: fotorealistyczne wizualizacje w 5 minut! Czy to koniec V-Raya?

Koniec z wielogodzinnym renderingiem? Sprawdź, jak zamienić prosty model 3D w gotową wizualizację dzięki AI. Zobacz workflow krok po kroku! -

![Homestaging z AI: Jak zmienić wystrój wnętrza na gotowym zdjęciu w Nano Banana Pro?]()

Homestaging z AI: Jak zmienić wystrój wnętrza na gotowym zdjęciu w Nano Banana Pro?

Klient chce inną sofę na gotowym renderze? Nie renderuj od nowa! Zobacz, jak zrobić wirtualny homestaging z AI w 5 minut.

Jakiego oprogramowania chcesz się nauczyć?

-

Sketchup

Liczba dostępnych kursów: 35

Łączny czas trwania kursów: 186 godzin![]()

-

3ds Max

Liczba dostępnych kursów: 28

Łączny czas trwania kursów: 322 godzin![]()

-

Archicad

Liczba dostępnych kursów: 25

Łączny czas trwania kursów: 138 godzin![]()

-

Revit

Liczba dostępnych kursów: 18

Łączny czas trwania kursów: 89 godzin![]()

Szukasz czegoś innego?